- รับลิงก์

- X

- อีเมล

- แอปอื่นๆ

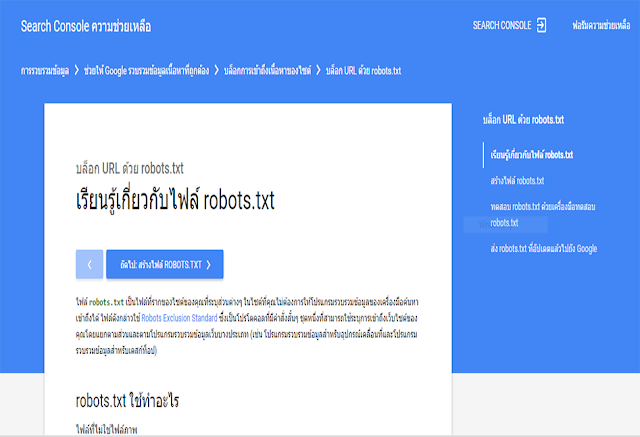

robots.txt มีไว้เพื่อป้องกันไม่ให้บอทของ Search Engine ต่างๆ เช่น Google มาเก็บข้อมูลเว็บไซต์ของเรา หรือ เฉพาะหน้าบางหน้า ไฟล์บางไฟล์ที่เป็นความลับ ไม่ต้องการให้บุคคลภายนอกรู้

ไฟล์ดังกล่าวใช้ Robots Exclusion Standard เป็นโปรโตคอลที่มีคำสั่งสั้นๆ ชุดหนึ่งที่ใช้ในการระบุการเข้าถึงเว็บไซต์ของคุณโดยแยกตามส่วนและตามบอทที่มาเก็บข้อมูล

หลังจากที่เขียนเสร็จแล้วก็ให้นำเอาไปวางไว้ใน root ของ server นะครับ แต่วิธีนี้เอาเป็นช่องโหว่ให้ผู้ที่ไม่ประสงค์ดีแอบเข้ามาดู แล้วเข้าไปได้ จึงควรทำพร้อมกับเข้ารหัสไฟล์ไปพร้อมกัน

อีกประการ สำหรับผู้ที่ไม่ต้องการให้แสดงหน้าที่คล้ายกัน ไม่ควรใช้ robots.txt เนื่องจากผลการค้นหาจากหน้าอื่นอาจชี้ไปยังหน้าดังกล่าว ทำให้ถูกจัดทำดัชนีด้วยวิธีนี้ แต่ควรใช้วิธี noindex แทน

อ่านเพิ่มเติม : ที่นี่

ไฟล์ดังกล่าวใช้ Robots Exclusion Standard เป็นโปรโตคอลที่มีคำสั่งสั้นๆ ชุดหนึ่งที่ใช้ในการระบุการเข้าถึงเว็บไซต์ของคุณโดยแยกตามส่วนและตามบอทที่มาเก็บข้อมูล

- ไม่ต้องการให้บอททุกตัวมาเก็บข้อมูล

User-agent : *

Disallow : /- ต้องการให้บอททุกตัวมาเก็บข้อมูล

User-agent : *

Allow : /- ต้องการให้บอทเฉพาะ Google มาเก็บข้อมูล

User-agent : googlebot

Allow : /- ต้องการให้บอทเฉพาะ Google-News มาเก็บข้อมูล

User-agent : googlebot-news

Allow : /- ไม่ต้องการให้บอททุก Search Engine มาเก็บข้อมูลเฉพาะบางไฟล์

User-agent : *

Disallow : /folder

Disallow : /file

Disallow : /*.jpg$หลังจากที่เขียนเสร็จแล้วก็ให้นำเอาไปวางไว้ใน root ของ server นะครับ แต่วิธีนี้เอาเป็นช่องโหว่ให้ผู้ที่ไม่ประสงค์ดีแอบเข้ามาดู แล้วเข้าไปได้ จึงควรทำพร้อมกับเข้ารหัสไฟล์ไปพร้อมกัน

อีกประการ สำหรับผู้ที่ไม่ต้องการให้แสดงหน้าที่คล้ายกัน ไม่ควรใช้ robots.txt เนื่องจากผลการค้นหาจากหน้าอื่นอาจชี้ไปยังหน้าดังกล่าว ทำให้ถูกจัดทำดัชนีด้วยวิธีนี้ แต่ควรใช้วิธี noindex แทน

อ่านเพิ่มเติม : ที่นี่

ความคิดเห็น

แสดงความคิดเห็น